导语:今天,腾讯传媒的全媒派发布了一篇《内容审核员成高危职业,互联网的黑暗面究竟有多可怕?》的文章,讲述了内容审核员所遇到的痛苦与挣扎。网易易盾取得了此文的转载授权,希望让更多的人了解内容审核人员的现状,从而形成共识,加大投入改善目前局面。

如果没有内容审核员,我们的互联网世界会是什么样子?或许,仇恨、暴力、血腥、色情的内容将充斥各个平台。光是想象一下这种乱象,就足够劝退很多用户了。

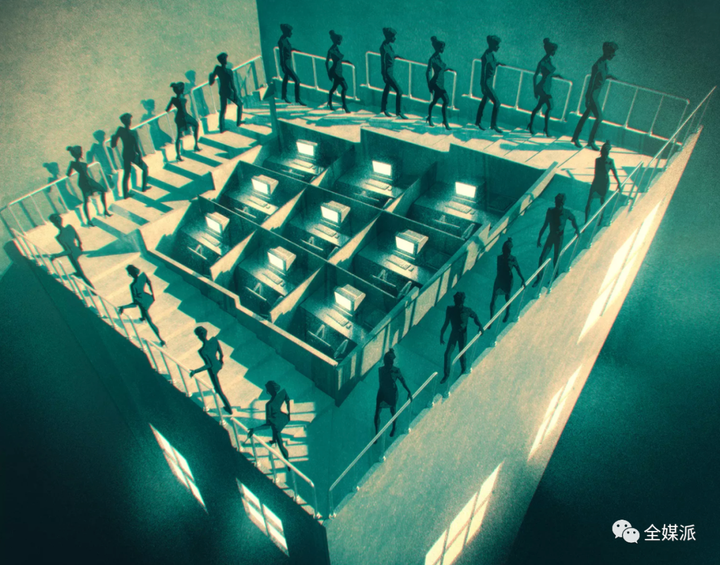

幸好,被称为”互联网清洁工“的内容审核员正保护着我们的双眼和大脑。但实际上,作为过滤者的他们也饱受着负面信息过载的困扰,《发条橙》的情节以另一种方式在这些人身上上演。

值得我们思考的是,对于这些承载了互联网世界黑暗面的审核员来说,当前业界是否给予了充分的关注?行业内是否存在合理的保护机制?

本期全媒派(ID:quanmeipai)聚焦互联网行业中这群“凝视深渊,也被深渊回以凝视”的特殊群体,透视他们的痛苦与挣扎,与你一同寻找困境的出路。

按照大多数互联网公司的规定,审核员不能泄漏自己的工作内容,换句话说,他们需要在大众视野中隐身,独自消化那些常人难以接受的负面内容。

实际上,对于大多数审核员来说,观看暴力、血腥等恐怖内容简直就是家常便饭,那些令人不适的画面甚至经常毫无征兆地出现,带来巨大的视觉和情绪冲击。由于长期阅读阴谋论等观点,很多审核员已经变得麻木而没有辨识能力,他们中的一些人现在甚至相信地球是平的。

此外,在Facebook这样的公司中,社区内容审核的准则几乎每天都会发生一些细微的改变,而审核员如果一周内多次发生判断失误,就可能被解雇,如此严苛的考核标准也让这份工作变得异常困难,这导致内容审核职业成了恐慌症等心理问题发作的重灾区。

与此同时,许多作为外包合同工的审核员的待遇水平并不与其高压的工作内容相称。他们通常享受不到正式员工同等的薪资和福利保障。平均来看,审核员的时薪为每小时18.5美元,只略高于美国最低工资,而且很难争取到加薪的机会。

在一次员工大会上,Facebook的CEO马克·扎克伯格承认了审核员这一岗位的高危性:“Facebook的信息安全团队在全球一共有3万人,他们的工作内容更加特殊。我们希望尽自己所能,全力支持这些员工。”

2019年,Facebook的前审核员Chris Gray在爱尔兰高等法院针对Facebook和CPL Solutions提起诉讼,理由是自己在Facebook工作的一年间遭受了严重的心理创伤。

Gray日常审核的视频包括大量虐待、行刑等场面,久而久之,自己的性格和心理状况都发生了很大改变。“我变得麻木和暴躁,越来越具有攻击性。”他表示,“每次回想起工作内容,我的心情都会一下子跌落谷底,只有逃避能让我暂且忘记那些可怕的画面。我已经连续一个星期没有睡着过了。”

当然,不只是Facebook,包括谷歌、YouTube在内的科技公司的审核员都有类似遭遇,这已经成为一种行业普遍现象。

然而,大多数人缺乏对审核员处境的基本理解,这些公司的管理层倾向于把这种状况描述为招聘失误,他们认为有些人面对负面信息天然有较高的抗压能力,而有些则不具备。

与之相反,审核员的健康状况从来就不是一个有或者没有的二元问题,更真实的情况是,有些审核员在入职后前几周就会出现PTSD的早期症状,另外一些人则会在工作多年后患上相关心理疾病。

YouTube的审核员Peter表示自己在离职后,再也无法轻松地观看动作片,对他而言,每一声枪响、每一次死亡都失去了虚构性,因而变得无比真实痛苦。

Peter的项目团队旨在为儿童创造更安全的网络环境,讽刺的是,却没有人来保卫审核员的安全。Peter团队内的其他成员大多也出现了心理问题,他的前任同事甚至因此染上了毒品,他说:“刚开始工作的时候,大家每天相互问候,氛围很好,但没过多久,就没有人愿意说话了。”

谷歌的研究人员认为:“目前越来越多人已经意识到,这个岗位不仅仅是带来单纯的不愉快情绪,长期大量地观看负面内容会让审核员造成严重的健康损伤。”

因审核负面内容引发心理问题,在行业内已经不是个例。2018年9月,一位名叫Selena Scola的审核员向Facebook提起诉讼,认为后者设置的高风险工作内容导致她出现心理健康问题,在连续9个月观看谋杀、自杀等图像内容后,Scola被诊断为出现PTSD症状。

今年2月7日,法庭文件显示双方达成了初步和解。在本案中,Facebook承认内容审核工作会给员工带来巨大的伤害,并同意向在职及离职的审核员支付总额为5200万美元的赔款,用以补偿他们因工作产生的心理健康问题。如果被诊断出患有PTSD或其他相关疾病,每名审核员将获得至少1000美元的赔偿。

作为和解协议的一部分,Facebook还表示将对内容审核程序进行修改,包括更改审核工具,将视频变为黑白模式,以及承诺提供更多心理咨询服务,每月举行一次集体治疗活动等等。

Facebook的举措是具有里程碑意义的,Scola的律师Steve Williams说:“我们为Facebook提供的方案倍感欣慰,因为这项会产生切实伤害的工作是近年来新兴的,没有太多先例可以学习,Facebook创造了有意义的解决思路。”

此次和解涉及从2015年起就为Facebook工作的11250名审核员,经过与创伤处理问题专家的咨询,Williams估计其中有超过一半的人能够争取到额外赔偿。换句话说,如果有人选择Facebook的审核员工作,那么其将有二分之一的概率需要承受工作带来的心理损伤。

另一个值得关切的问题是:审核员究竟能拿到多少赔偿?首先,本案获得的赔偿中有32.7%要用于支付律师费用,其次,剩下的3500万美元是由所有人共享的。由此看来,5200万美元这一数字似乎也不是太令人满意。

赔偿会分层次进行:第一次赔偿是给每个人发放基础的1000美元,用于支付审核员进行心理检查的费用;这之后,对于那些确诊的审核员,公司会根据病情的严重程度,给予额外1500至6000美元的补偿。此外,审核员还可以提交证据证明自己因工作遭遇到的困扰,以获得每人最高5万元的赔偿。

审核员实际拿到的赔偿金额主要取决于究竟有多少人被认定有资格获得额外赔偿。假设有一半左右的人申请到了额外赔偿,那么每个审核员平均可以获得4222.22美元。

这样算下来,每个人的最终赔偿并不算多。在社交网站上,很多人也表示Facebook支付的赔偿太少了。

与此同时,在审核员的遭遇引起普遍关注后,2019年,Facebook的外包公司Cognizant宣布由于和整体战略构想不符,公司将在2020年逐步停止其内容审核业务,因业务变动而失业的员工将获得遣散费、奖金以及各种培训机会。

还有一些公司通过与员工签订知情协议的方式来规避法律纠纷,据The Verge的报道,YouTube的业务外包公司埃森哲(Accenture)要求审核员事先签署一份承认该工作可能会导致PTSD的文件,并表示不承诺为因工作而患上PTSD的员工提供援助。法律专家认为,这份文件中的相关规定可能是违反劳动法的。

是否有更好的方式减轻审核员的痛苦?

谷歌的审核员Daisy负责清理儿童性虐待图片(CSAI),但工作一年后,她出现了明显的心理障碍。

在主管提示其需要提高工作效率后,Daisy感到愤怒:“我该如何增强生产力?我的大脑充斥着糟糕的内容,我们是有血有肉的人类,而不是机器。”

那么,是否存在更好的方式来减轻审核员的痛苦?

谷歌负责信任和安全业务的副总裁Kristie Canegallo说:“我们的责任以及对员工的承诺就是为他们提供充足的支持,公司在改善员工工作条件方面取得的任何进展都将与业界共享。”

去年,谷歌的研究团队在“人类计算与众包大会”(Conference on Human Computation and Crowdsourcing)上发表了一篇题为《风格化干预措施对减少内容审核人员情绪的影响》(Testing StylisticInterventions to Reduce Emotional Impact of Content Moderation Workers)的论文,文中记录了谷歌对其审核员进行的两项实验。

在一项实验中,谷歌将所有的视频设置为灰度显示,在另一项中,内容经过模糊化处理。研究人员希望了解的是,改造图像是否能够减轻其对审核员的情绪影响。

76名审核员参与了实验,他们需要在前两周观看常规的彩色图像,在后两周观看灰度图像,并分别填写问卷调查。研究结果显示,灰度显示模式的确让审核员的情绪出现明显好转。

谷歌的研究人员建议,未来的实验可以考虑从以下几个方面进行:把血液换成绿色、对内容进行艺术处理。

此外,Canegallo还表示,谷歌的确正致力于开发机器学习系统来抓取包含不良内容的视频,但在技术应用的初期,审核员依然是不可或缺的,他们需要帮助训练系统。在此之后,人工审核就可以被取代了。

实际上,科技公司们一直知道审核员承受的心理压力,但是却在首例员工报告PTSD诊断结果多年后的今天,才开始考虑通过技术手段进行干预。

对此,一位任职于科技公司的员工提到了“有毒物质侵权”(Toxic Torts)这一概念,意指如果接触到了不利于健康的危险化学物质,人们有权通过法律起诉相关雇主或者房地产商,这项法律实行的基础在于人类关于化学物质对人体的影响已经掌握了科学的认识,因而可以制定安全的行业标准。

但遗憾的是,我们难以用同样严谨精确的标准来衡量审核员所面临的危险。

尽管如此,人们没有放弃自己的权益,谷歌的员工就正在带领行业关注外包审核员的处境,并协助他们进行维权。

总而言之,改变现状并非不可能,这有赖于劳动者、公司和公众的共同努力。